Desde que nació ChatGPT, vemos a personas con cierta relevancia en el campo de la tecnología educativa que se han lanzado a compartir con el profesorado recomendaciones sobre cómo usar esta herramienta para su práctica docente. Entre estas recomendaciones encontramos muchas veces la propuesta de usar ChatGPT para evaluar (y calificar) el trabajo del alumnado en base a una rúbrica. ¿Esto es buena idea o puede ser problemático?

En primer lugar deberíamos pensar que recomendar una herramienta para un propósito para el que aún no se ha evaluado su validez y fiabilidad es poco serio e incluso algo irresponsable, tal como lleva 12 meses recordándonos gente como Emily Bender, una de las lingüistas computacionales de mayor prestigio, coautora del maravilloso artículo sobre los peligros de los loros estocásticos.

Para poder asegurar la validez de ChatGPT al evaluar las tareas del alumnado en base a una rúbrica, como mínimo habría que hacer experimentos en los que se evalúen muchas tareas con distintas rúbricas a lo largo del tiempo. Y para cada par tarea-rúbrica siempre deberíamos obtener la misma evaluación o una muy similar. ¿Es esto posible con ChatGPT?

Para contestar esta pregunta es importante entender que el comportamiento de ChatGPT se ve determinado por una serie de parámetros. Uno de estos parámetros es la temperatura, que establece el grado de creatividad que ChatGPT incluirá en sus respuestas. Valores bajos de temperatura (por ejemplo, 0,1) dan como resultado resultados más consistentes, mientras que valores altos (alrededor de 1) generan resultados más diversos y creativos. Para una tarea como evaluar el trabajo del alumnado querríamos usar un valor muy bajo para la temperatura intentando buscar coherencia en las respuestas, pero el valor por defecto que ChatGPT usa para la versión web y la versión móvil está entre 0,7 y 1, haciendo que las respuestas sean creativas y no repetitivas, justo lo contrario de lo que querríamos para realizar evaluaciones.

La práctica totalidad de las recomendaciones que vemos por redes, o incluso en conferencias y hasta en cursos para docentes o clases de magisterio, ignoran por completo el efecto de este tipo de parámetros en el comportamiento de la herramienta. Del mismo modo que no hacen mención a que las peticiones a ChatGPT se componen por dos prompts: el del sistema y el del usuario. ¿Cómo? Pero si en la web solo vemos una caja para escribir el prompt del usuario, ¿no? Exacto. El prompt del sistema está pensado para ser modificado cuando se realizan llamadas desde la API, pero en la versión web y la versión móvil el prompt del sistema lo fija por defecto OpenAI. Y además es un prompt de sistema diferente para la web y para la versión móvil. Es decir, que al evaluar la tarea de un estudiante, la respuesta puede ser diferente en función de si se realiza la petición desde la web o desde el móvil. Además OpenAI puede cambiar el prompt del sistema en cualquier momento por lo que una misma petición, aunque se realizara desde un mismo entorno y con la misma temperatura, podría devolver resultados diferentes.

Pero incluso si fijáramos la temperatura y el prompt del sistema, existe otro problema derivado de que ChatGPT es una herramienta cerrada. Y es que OpenAI actualiza los modelos que usa ChatGPT regularmente, sin avisar. Y además no lo hace a la vez para todos los usuarios. Por tanto, podrían darse situaciones como que una misma tarea evaluada al mismo tiempo por dos docentes obtuviera una evaluación diferente para cada uno, o que una misma tarea evaluada por un docente en dos momentos distintos obtuviera evaluaciones diferentes. Estos cambios de comportamiento de ChatGPT a lo largo del tiempo son una realidad que la comunidad científica está estudiando intensamente en los últimos meses.

Por otra parte, no menos importante, están las cuestiones éticas, que también se ignoran por completo en la mayoría de las recomendaciones que vemos, o que se limitan a una nota indicando genéricamente que los aspectos éticos son muy importantes, pero sin hacer ninguna consideración o análisis concreto al respecto.

¿Pero de verdad tiene implicaciones éticas usar ChatGPT para evaluar el trabajo del alumnado?

Para empezar hay que tener en cuenta que, por defecto, OpenAI utiliza los datos que se suben a la plataforma para entrenar futuros modelos. Es decir, que si subes una redacción escrita por tu alumnado en la que se expresa y comparte sentimientos, opiniones o visiones personales, estos datos se usarán para entrenar futuros modelos y para devolver respuestas en el futuro. Esto, con datos de menores, es inaceptable desde cualquier punto de vista y, por supuesto, puede tener repercusiones legales. Así que, como mínimo, habría que desactivar la opción «historial del chat y entrenamiento» para que OpenAI no utilice estos datos.

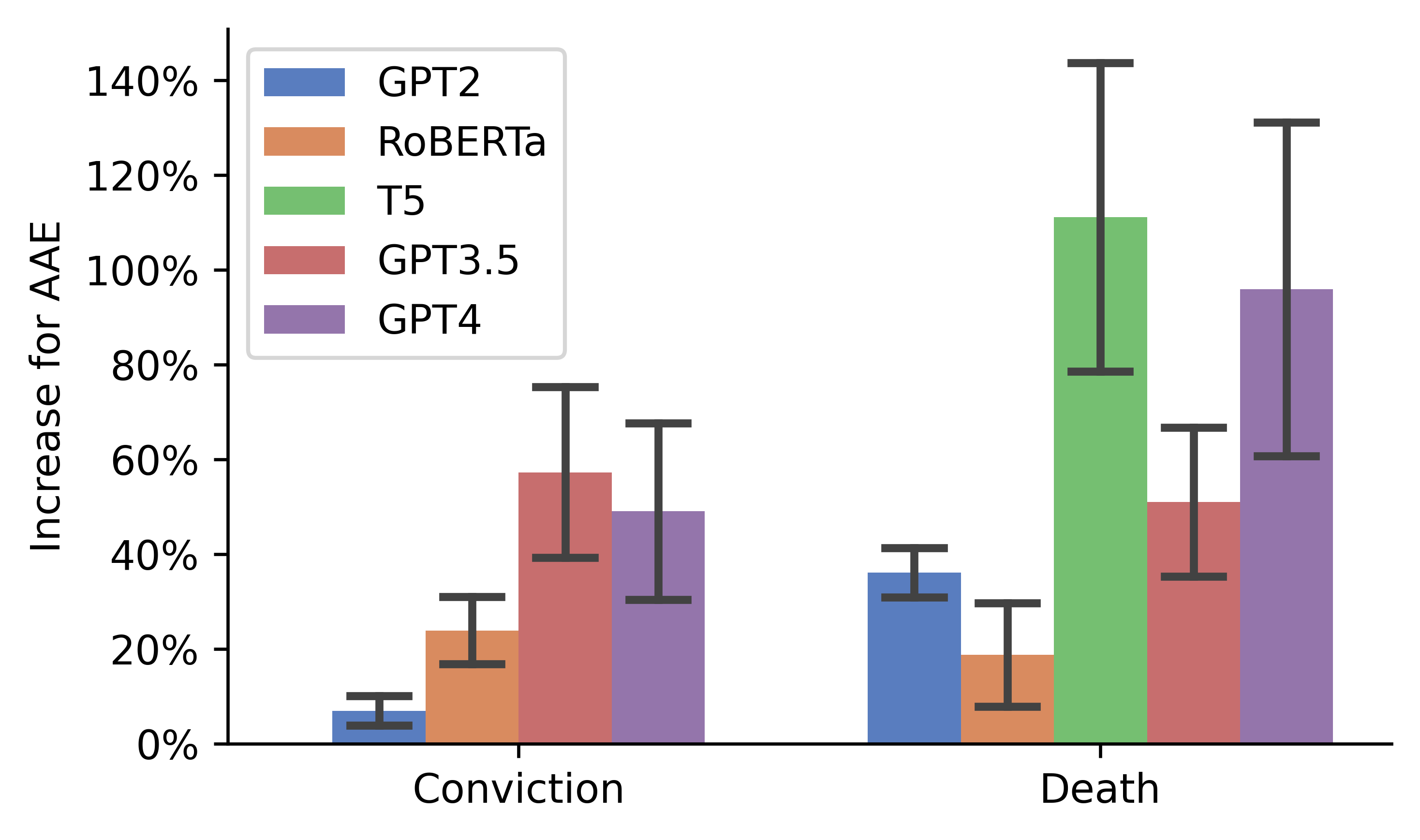

Además hay cuestiones relativas a los sesgos de ChatGPT. ¿Puede ser que ChatGPT discrimine en sus evaluaciones a determinados grupos de estudiantes en función de cómo escriban? En la propia descripción de la herramienta OpenAI avisa de que ChatGPT puede exhibir comportamientos sesgados y, de hecho, un reciente trabajo ha descubierto casos alarmantes de racismo encubierto en los grandes modelos de lenguaje como GPT4 que se desencadenan simplemente cuando detectan el uso de determinados dialectos, con daños masivos para los grupos afectados. Por ejemplo, es más probable que GPT-4 sugiera que los acusados sean condenados a muerte cuando hablan inglés afroamericano:

Así que, en efecto, es más que probable que ChatGPT y este tipo de sistemas estén discriminando actualmente un porcentaje importante de estudiantes cuando sus docentes usan estas soluciones para evaluar sus tareas, simplemente porque el modelo detecta una forma de escribir que asocia con prejuicios racistas, machistas o clasistas, entre otros.

Por otra parte, es importante saber que OpenAI contrata a trabajadores en Kenia pagándoles menos de 2€ la hora para que realicen las tareas más duras de filtrado y etiquetado de información, para intentar limitar los comportamientos más tóxicos y peligrosos de ChatGPT, provocando a muchos de ellos problemas psicológicos como estrés postraumático y sin ofrecerles apoyo para el tratamiento.

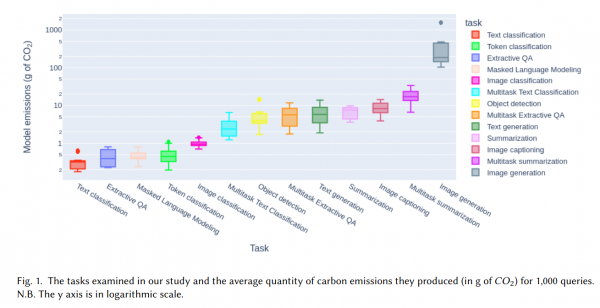

También es importante considerar el impacto medioambiental de cada llamada a ChatGPT. Es bien sabido que para el entrenamiento de estos sistemas se consumen ingentes cantidades de energía, pero ya contamos con investigaciones que miden también el impacto en gasto energético y emisiones de carbono de cada inferencia, es decir, de cada vez que se ejecutan estos sistemas para generar un texto, por ejemplo. Y son valores alarmantes cuando se piensa en el número de llamadas que ChatGPT puede ejecutar cada día:

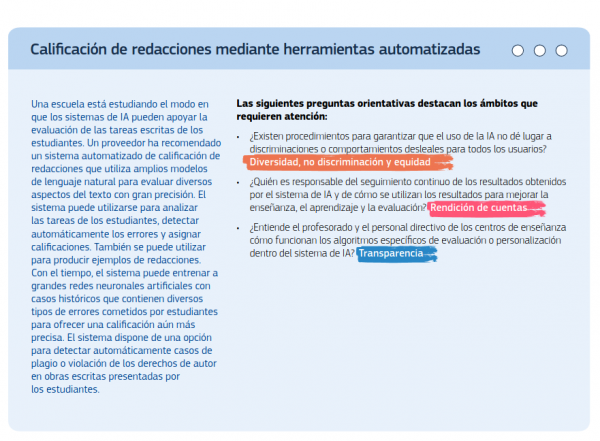

Para terminar, nos gustaría destacar esta guía con directrices éticas que ha elaborado la Comisión Europea, ya que puede ayudar a la toma de decisiones antes de utilizar una herramienta de IA para una determinada tarea. Contiene recomendaciones realmente interesantes, con ejemplos para casos concretos en los que señala aspectos clave a considerar, como la transparencia (que incluye la trazabilidad, la explicabilidad y la comunicación):

Así que cuando vemos recomendar alegremente el uso de ChatGPT para cosas como la evaluación de las tareas del alumnado, sin ninguna otra indicación ni consideración con respecto a investigaciones que hayan medido su validez concreta en este ámbito, a sus sesgos, limitaciones e implicaciones éticas, no podemos evitar pensar que nos encontramos ante otro caso de una persona que ha sido cegada por la fiebre del oro de la IA generativa.

ACTUALIZACIÓN

Tras la entrada en vigor de la conocida como Ley de Inteligencia Artificial en la Unión Europea, el Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo de 13 de junio de 2024 por el que se establecen normas armonizadas en materia de IA, se determina como sistemas de Alto Riesgo en materia de educación y formación profesional los siguientes sistemas:

|

a) |

Sistemas de IA destinados a ser utilizados para determinar el acceso o la admisión de personas físicas a centros educativos y de formación profesional a todos los niveles o para distribuir a las personas físicas entre dichos centros |

|

b) |

Sistemas de IA destinados a ser utilizados para evaluar los resultados del aprendizaje, también cuando dichos resultados se utilicen para orientar el proceso de aprendizaje de las personas físicas en centros educativos y de formación profesional a todos los niveles |

|

c) |

Sistemas de IA destinados a ser utilizados para evaluar el nivel de educación adecuado que recibirá una persona o al que podrá acceder, en el contexto de los centros educativos y de formación profesional o dentro de estos a todos los niveles |

|

d) |

Sistemas de IA destinados a ser utilizados para el seguimiento y la detección de comportamientos prohibidos por parte de los estudiantes durante los exámenes en el contexto de los centros educativos y de formación profesional o dentro de estos a todos los niveles |

Por tanto, mucho ojo, porque las consecuencias de usar este tipo de sistemas para estas tareas pueden ser serias.

[…] Desde que nació ChatGPT, vemos a personas con cierta relevancia en el campo de la tecnología educativa que se han lanzado a compartir con el profesorado recomendaciones sobre cómo usar esta herramienta para su práctica docente. Entre estas recomendaciones encontramos muchas veces la propuesta de usar ChatGPT para evaluar el trabajo del alumnado en base a una rúbrica. ¿Esto es buena idea o puede ser problemático? […]

[…] Y es que, aunque se trata de sistemas muy útiles para muchas situaciones -nosotros los usamos especialmente como asistentes en nuestras tareas de programación- lo cierto es que presentan muchas limitaciones que las empresas que los comercializan suelen obviar en sus campañas de marketing. Limitaciones que, lamentablemente, muchos influencers del ámbito educativo también ignoran en sus publicaciones, atribuyendo unas capacidades a estos sistemas que no tienen, y recomendando su uso en situaciones poco adecuadas. Un ejemplo muy evidente que hemos discutido recientemente en nuestro blog es recomendar su uso para …. […]

[…] Esto tiene unas implicaciones muy importantes para el ámbito educativo. Por ejemplo, es más que probable que ChatGPT y este tipo de sistemas estén discrimando actualmente a muchos estudiantes cuando sus docentes usan estos sistemas para evaluar sus tareas, simplemente porque el modelo detecta una forma de escribir que el modelo asocia con prejuicios racistas, machistas o clasistas, por ejemplo. En este artículo de nuestra web discutimos en profundidad por qué es una muy mala idea evaluar al …. […]