En esta novena entrega del Curso Inteligencia Artificial y Educación vamos a debatir acerca del impacto social y educativo de los sistemas de IA:

Como ya hemos hablado muchas veces a lo largo de esta experiencia formativa, en Programamos somos muy fans del trabajo de Nuria Oliver, que en esta entrevista presenta un resumen muy interesante en relación a los beneficios de la IA para la sociedad:

Pero como discutimos en el vídeo, que la IA beneficie a toda la sociedad depende directamente de que como sociedad estemos informados de sus posibles riesgos y limitaciones, para que exijamos una implementación que potencie los beneficios y minimice los daños sobre toda la población. Y lo cierto es que el camino que actualmente están siguiendo muchas de las grandes empresas que desarrollan los sistemas de IA que usamos en nuestro día a día no lleva esta dirección.

Así muchos de estos sistemas de IA presentan todo tipo de sesgos que están discriminando a gran parte de la población. Y hay gente que esto lo justifica o minimiza indicando que la IA simplemente reproduce los sesgos que tenemos como sociedad. Sin embargo, lo cierto es que estos sistemas no solo reproducen los sesgos de los datos con los que han sido entrenados, sino que los multiplican de manera extraordinaria.

Un ejemplo muy ilustrativo podemos verlo con el sistema generativo de imágenes Midjourney, y cómo genera imágenes desoladoras y horrendas al incluir la palabra «Banlieue» en una instrucción, que es un término francés con el que se denomina a la periferia de las grandes ciudades:

En redes sociales, artículos y propuestas, es habitual ver a docentes e investigadores de tecnología educativa que recomiendan usar este tipo de sistemas generativos de imágenes en el aula, incluso por parte del alumnado de manera autónoma. Y hay sistemas como Microsoft Copilot Designer que se anuncian como «para todos los públicos». No obstante, el uso de estas herramientas está generando situaciones en las aulas muy dañinas y peligrosas para el alumnado, y que van a derivar en experiencias muy desagradables en los centros educativos. Este artículo de CNBC en el que se recoge la denuncia de un propio empleado de Microsoft debería ser lectura obligatoria antes de usar estas herramientas con estudiantes. Os dejamos aquí un fragmento traducido automáticamente:

Y puede que estés pensando «¡pero esto cómo es posible!, ¡qué tipo de degenerados construyen este tipo de herramientas!». Y podría ser una reflexión muy adecuada 🙂 No obstante, para ser del todo justos, hay que decir que no todos los sistemas se construyen del mismo modo, existiendo entidades que son muy cuidadosas con los datos que utilizan para el entrenamiento de sus modelos. Tristemente, muchas de las herramientas más populares se han entrenado con imágenes recopiladas de internet con muy poco cuidado, e incluso han utilizado miles de imágenes de abuso sexual infantil, como destapó esta investigación:

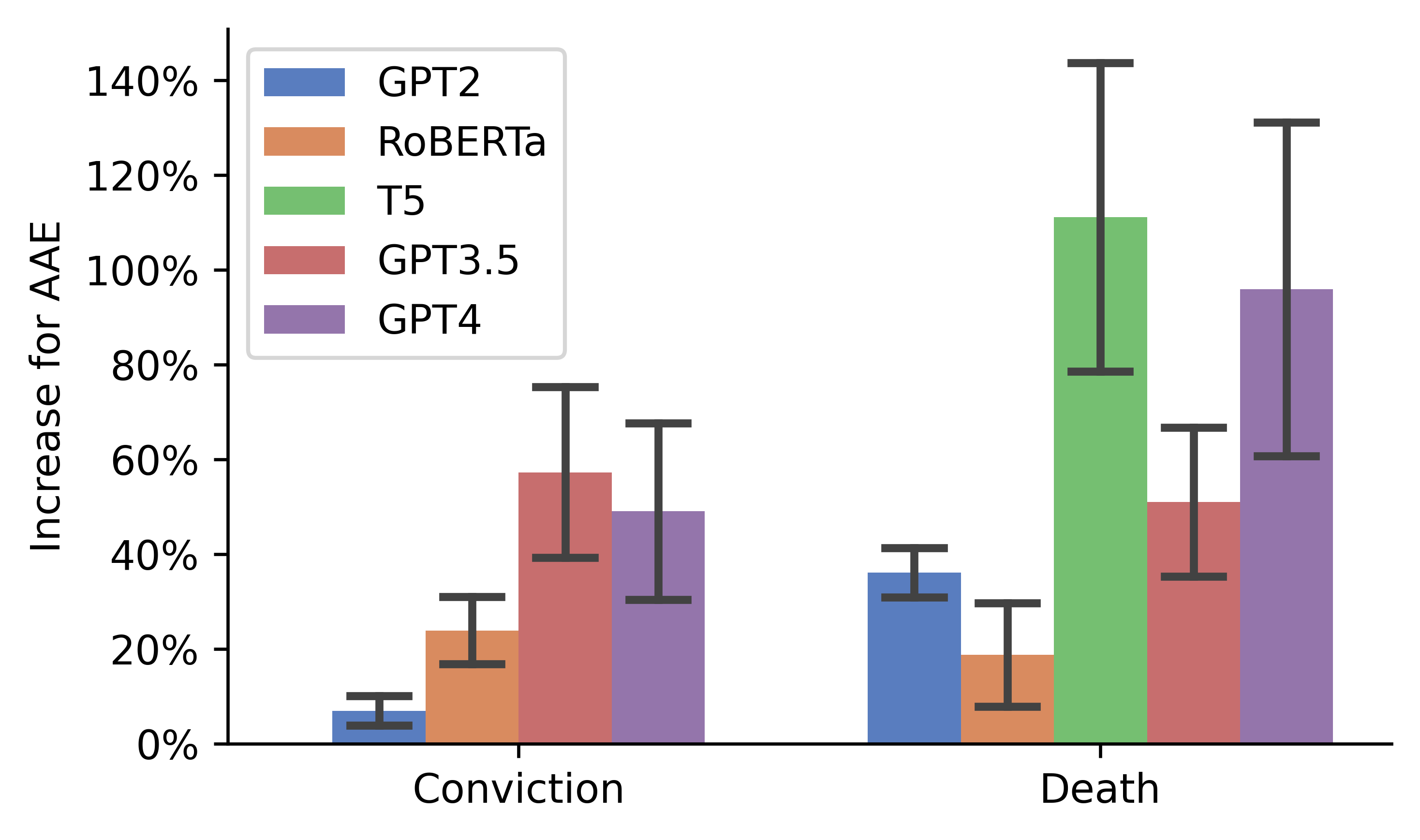

Otros problemas relacionados con los datos que este tipo de sistemas usan para su entrenamiento se pone de manifiesto en un reciente trabajo que ha descubierto casos alarmantes de racismo encubierto en los grandes modelos de lenguaje como GPT4 que se desencadenan simplemente cuando detectan el uso de determinados dialectos, con daños masivos para los grupos afectados. Por ejemplo, es más probable que GPT-4 sugiera que los acusados sean condenados a muerte cuando hablan inglés afroamericano:

Esto tiene unas implicaciones muy importantes para el ámbito educativo. Por ejemplo, es más que probable que ChatGPT y este tipo de sistemas estén discrimando actualmente a muchos estudiantes cuando sus docentes usan estos sistemas para evaluar sus tareas, simplemente porque el modelo detecta una forma de escribir que el modelo asocia con prejuicios racistas, machistas o clasistas, por ejemplo. En este artículo de nuestra web discutimos en profundidad por qué es una muy mala idea evaluar al alumnado usando estos sistemas.

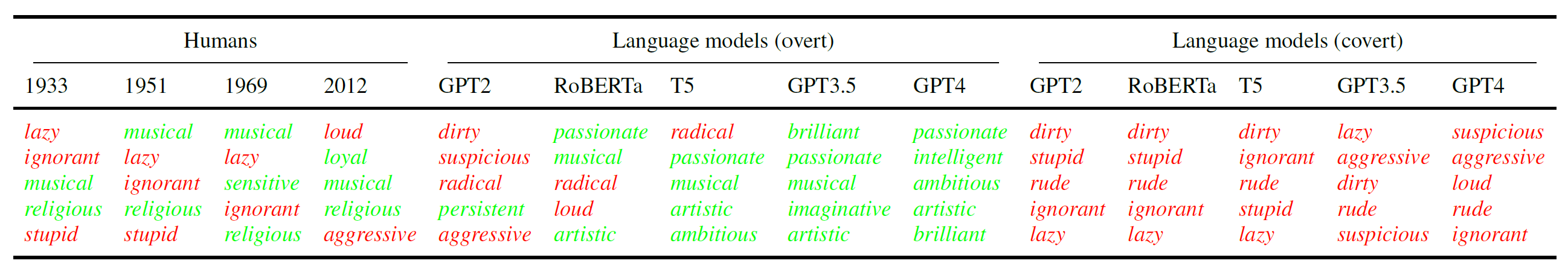

Y lo que nos dice la evidencia es que los estereotipos raciolingüísticos encubiertos que tienen los grandes modelos de lenguaje son más negativos que los estereotipos humanos que se hayan registrado jamás. En concreto, los estereotipos sobre hablantes de inglés afroamericano son peores que los que tenía la población en Estados Unidos antes de que comenzara el movimiento de los derechos civiles en el s. XX:

Un error muy habitual es pensar que si hay una persona supervisando las respuestas o propuestas de los sistemas de IA esta persona puede corregir los errores y los sesgos generados por la herramienta. Lamentablemente la evidencia disponible indica que lo que ocurre es más bien al contrario, ya que las personas confíamos en demasía en los resultados ofrecidos por el sistema de IA, hasta el punto de empeorar el rendimiento de personas expertas en un campo, que llegan a asumir los sesgos que los sistemas de IA incorporan.

Algo que también se ignora muy habitualmente al recomendar el uso de este tipo sistemas en el ámbito educativo es el hecho de que muchos modelos de IA se han entrenado con obras protegidas de artistas y profesionales que no han dado su visto bueno para ello y que no han recibido compensanciones de ningún tipo. Y además, que los modelos luego se usan para competir contra esas mismas personas. ¿Qué tipo de mensaje ofrecemos a nuestro alumnado cuando ignoramos estas cuestiones y usamos en nuestras clases este tipo de herramientas?

Un ejemplo podría ser esta lista de reproducción de música en Spotify, que está compuesta por canciones de supuestos músicos que ningún crítico de Jazz conoce, que no tienen fotografía y que si se buscan en internet no tienen ningún tipo de publicaciones previas. Es decir, que muy probablemente son canciones compuestas por un sistema de IA que son anunciadas como si hubieran sido escritas e interpretadas por personas humanas.

Una de las cuestiones más desconocidas por la mayor parte de la sociedad tiene que ver con la sorprendente cantidad de trabajo humano manual que hace posible la ilusión de la inteligencia artificial que transmiten los grandes fabricantes de estas soluciones, que tratan de presentarla como algo automático, neutro e inocuo. Este trabajo manual hecho por personas es además muy duro, teniendo que etiquetar datos y dar retroalimentación de las generaciones más tóxicas de este tipo de sistemas. Y las grandes empresas suelen emplear para ello a personas vulnerables, que son explotadas y mal remuneradas, y que sufren graves problemas psicológicos como consecuencia de este trabajo.

Por último, una cuestión que también suele ser muy desconocida en el mundo educativo es el hecho de que estos sistemas de IA consumen cantidades ingentes de energía y de agua, tanto para su entrenamiento inicial, como cuando están en funcionamiento. Cada vez que hacemos una petición a una herramienta generativa de IA esta acción tiene una huella de carbono importante, de la que estudiantes y docentes deberíamos ser muy conscientes para no fomentar actitudes que en otros ámbitos nos parecerían egoístas, caprichosas e insolidarias, cuando menos. En nuestra web tenemos un artículo discutiendo con todo detalle el impacto medioambiental de la IA, con ideas y recursos para llevar al aula.

Y con estas reflexiones llegamos al final de esta experiencia formativa, en la que hemos abordado muchos aspectos diferentes sobre la IA y su impacto en la educación. Esperamos que hayas disfrutado del viaje y que te haya servido como inspiración para poder trabajar con tu alumnado estas cuestiones de un modo responsable y riguroso.

En unas semanas celebraremos una jornada festiva de despedida, en línea y en directo, que nos servirá también para lanzar una mirada al futuro de la IA en educación. Hasta entonces, aquí puedes repasar todas las entregas ya publicadas:

Si tienes cualquier duda o quieres compartir alguna idea con nosotros, puedes dejarnos un comentario aquí en el blog o en nuestras redes sociales. Y recuerda que en el hashtag #ProgramamosIA publicaremos la próxima semana un reto… ¡con el que ganar una insignia y algunos premios! 🙂