Desde hace varios años en Programamos hemos escrito sobre la importancia de que todos los estudiantes aprendan acerca de algoritmos e inteligencia artificial (IA) en la escuela. No porque creamos que todo el alumnado vaya a ser desarrollador de este tipo de sistemas en el futuro, si no porque ya vivimos rodeados de ellos y es fundamental que toda la sociedad sea capaz de reconocerlos, preguntar sobre ellos y cuestionarlos cuando su uso o comportamiento no sea el adecuado.

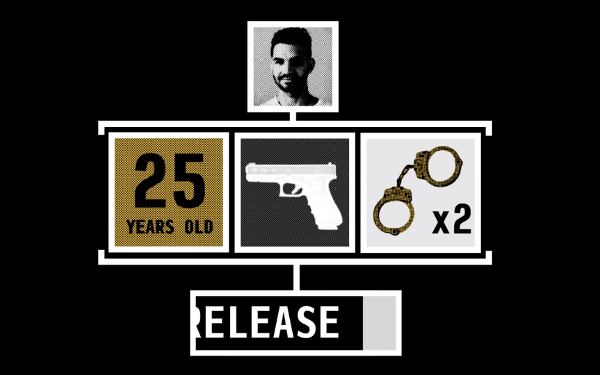

Uno de los ejemplos que siempre ponemos es el de COMPAS, un sistema de IA utilizado en los juzgados de Estados Unidos que ofrece a los jueces información sobre la posibilidad de que un detenido pueda cometer otro crimen antes de su juicio, y que los jueces usan para ayudarles a decidir si dejan al acusado en libertad o en la cárcel hasta el juicio. Este sistema saltó a las noticias hace un tiempo porque se comprobó que los acusados de raza negra tenían el doble de posibilidades que los de raza blanca de ser catalogados como alto riesgo.

Hoy os trasladamos un reto que han lanzado desde Technology Review, para que intentes lograr que tu algoritmo sea más justo que COMPAS. Se trata de una herramienta fantástica que nos puede ayudar a que seamos conscientes de cuán difícil es eliminar estereotipos raciales o de otros tipos en los algoritmos de IA, incluso cuando los datos que alimentan al propio algoritmo no contienen esta información. Y lo bueno de esta actividad interactiva es que permite llevarla al aula y jugar con los diferentes valores sin tener que saber nada de programación

Desde nuestro punto de vista, este tipo de actividades son ideales para escuelas e institutos, puesto que introducen de manera natural la idea de que podemos y debemos cuestionarnos si las soluciones de IA con las que interactuamos están ofreciendo resultados justos, para que no sean tratadas como si fueran soluciones mágicas perfectas -que, lamentablemente, es el modo con el que una parte importante de la socidad se relaciona con ellas actualmente. De este modo estaremos acostumbrando a nuestro alumnado a exigir que los sistemas de IA ofrezcan transparencia sobre su proceso de toma de decisiones.

¿Te animas a acercar cuestiones éticas de la IA a tu aula?

La imagen de cabecera es una captura de pantalla

del propio artículo de Technology Review.

[…] el problema se produce por los datos utilizados para entrenar al sistema, tal como discutíamos hace unos días en este artículo sobre el sistema COMPAS, parece claro que hay que trabajar en mejorar estos datos de entrenamiento. Baeza-Yates y Peiró […]