Dr. Scratch es una herramienta que permite analizar de forma sencilla y automática proyectos Scratch para evaluar el grado de desarrollo del pensamiento computacional. Como parte del proceso de validación de la herramienta, un grupo formado por investigadores de las Universidades URJC, UNED y Northeastearn University, en colaboración con Programamos, hemos desarrollado un estudio para comprobar la relación entra las puntuaciones que otorga Dr. Scratch con las de evaluadores expertos. Y lo cierto es que los resultados son realmente interesantes.

¿Cómo se ha desarrollado la investigación?

Los proyectos Scratch que se han utilizado para la investigación son los de los participantes del concurso de programación Dr. Scratch, cuya entrega de premios celebramos en Google Campus en diciembre de 2015.

Un momento de la entrega de premios del concurso de programación Dr. Scratch

Para el concurso contamos con 16 expertos en evaluación de proyectos Scratch que participaron como miembros del jurado, así que hemos usado sus más de 450 evaluaciones para compararlas con las puntuaciones que asigna Dr. Scratch a esos mismos proyectos.

Los resultados

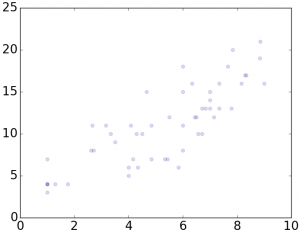

Las correlaciones entre las puntuaciones de Dr. Scratch y las evaluaciones de los expertos son muy fuertes, lo que puede considerarse una validación del análisis de pensamiento computacional que realiza la herramienta. Así, la siguiente figura muestra la clara relación positiva que existe entre las puntuaciones de Dr. Scratch (que van de 0 a 21 puntos) y las de los expertos (entre 0 y 10):

Las puntuaciones de los expertos están en el eje x, y las de Dr. Scratch en el eje y

Las relaciones entre ambas puntuaciones se han estudiado desde varios puntos de vista, y los resultados indican que aprendices y docentes pueden confiar en Dr. Scratch como herramienta de apoyo en las tareas de evaluación del pensamiento computacional.

Para los que tengáis interés en conocer todos los detalles del estudio, podéis acceder a una copia completa del artículo, que acaba de publicarse en la prestigiosa conferencia ACM CHI Conference on Human Factors in Computing Systems.

Agradecimientos

Esta investigación no podría haberse desarrollado sin los participantes en el concurso, que enviaron unos proyectos fantásticos, los expertos del jurado y los patrocinadores (FECyT y Google). Además, se ha financiado parcialmente el estudio gracias proyecto “eMadrid – Investigación y Desarrollo de tecnologías para el e-learning en la Comunidad de Madrid” (S2013/ICE-2715), así como al proyecto europeo SÉNECA, una acción Marie Skłodowska-Curie. A todos vosotros, ¡muchas gracias!

[…] en base a una medida cuantitativa, la puntuación de pensamiento computacional proporcionado por Dr. Scratch. A continuación triangulamos los resultados estudiando cualitativamente y en detalle el código […]

Si, me interesa este curso gratuito